Foto: Samantha Lee/Business Insider

/ materiały prasowe

Nie jest jasne, kiedy dokładnie wynaleziono "deepfakes", ale technologia zaczęła

zyskiwać na popularności pod koniec 2017 roku. Opublikowano wtedy

spreparowany film porno rzekomo przedstawiający znaną aktorkę.

Klip pojawił się w serwisie Reddit.

Niebezpieczny internetowy trend może przyczynić się do zniszczenia twojej reputacji. Nikt nie wie, co z nim zrobić

Na nagraniu, które pojawiło się w sieci w czerwcu, widzimy Marka Zuckerberga, który wpatruje się w kamerę, siedząc za biurkiem. Wygłasza krótką mową skierowaną do widzów. – Wyobraź to sobie. Jeden człowiek z całkowitą kontrolą nad skradzionymi danymi miliardów ludzi. Wszystkie ich sekrety, ich życie, ich przyszłość – mówi.

Na nagraniu nie widzimy jednak prezesa Facebooka, ale jego cyfrową replikę znaną jako deepfake: fałszywe wideo stworzone przy użyciu sztucznej inteligencji, które może wyglądać, jakby konkretna osoba powiedziała lub zrobiła coś, czego tak naprawdę nigdy nie mówiła, ani nie robiła.

W filmach tego typu zobaczyć można dobrze rozpoznawalne twarze: od Kita Haringtona z "Gry o tron" po byłego prezydenta USA Baracka Obamę. Niektóre filmy mogą być nieszkodliwe – jak np. nagranie, na którym Jon Snow (grany przez wspomnianego Haringtona) przeprasza za zakończenie serialu "Gra o tron". Technologia wzbudza jednak poważne obawy. Manipulowanie filmami i zdjęciami z wykorzystaniem sztucznej inteligencji może być wykorzystane do rozpowszechniania błędnych informacji lub niszczenia reputacji konkretnych osób.

Według ekspertów rozwój deepfake'ów nie zwolni w najbliższym czasie.

– Patrząc na to pod kątem technologii, nic nie możemy zrobić – mówi Ali Farhadi, starszy kierownik ds. badań w grupie zajmującej się rozpoznawaniem obrazów w Allen Institute for Artificial Intelligence – Ta technologia istnieje, a ludzie mogą zacząć wykorzystywać ją w dowolny sposób – tłumaczy.

"Wkraczamy w erę, w której nasi wrogowie mogą zmusić kogokolwiek do wypowiedzenia dowolnych słów w dowolnym momencie"

Nie jest jasne, kiedy dokładnie wynaleziono "deepfakes", ale technologia zaczęła zyskiwać na popularności pod koniec 2017 roku, kiedy to fałszywy film porno rzekomo przedstawiający aktorkę Gal Gadot został opublikowany na Reddicie przez użytkownika, posługującego się pseudonimem "deepfakes".

Od tego czasu w sieci pojawiło się wiele spreparowanych filmów z udziałem celebrytów i polityków - niektóre z nich mają być satyryczne, inne przedstawiają osoby publiczne w negatywnym świetle, a jeszcze inne stworzono, aby poprzeć konkretny punkt widzenia. Na początku 2018 roku popularne były wideoklipy ze słynnych scen filmowych, które zostały cyfrowo zmienione, by nałożyć na postacie twarz aktora Nicholasa Cage'a. To ta lżejsza i mniej szkodliwa strona problemu. Pokazuje, że technologia mogłaby wręcz pomóc branży rozrywkowej.

W kwietniu 2018 roku BuzzFeed zamieścił na stronie niesamowicie realistyczny – ale fałszywy – film, przedstawiający byłego prezydenta Baracka Obamę, wypowiadającego słowa, których w rzeczywistości nigdy nie wypowiedział. Serwis chciał przedstawić zagrożenia, jakie niesie ze sobą wykorzystanie technologii w niecny sposób. – Wkraczamy w erę, w której nasi wrogowie mogą zmusić kogokolwiek do wypowiedzenia dowolnych słów w dowolnym momencie – mówi "fałszywy Obama" w filmie.

Facebook znalazł się w ogniu krytyki po tym, jak odmówił usunięcia spowolnionego filmu z Nancy Pelosi, spikerką Izby Reprezentantów. Wideo spreparowano w taki sposób, by wydawało się, że Pelosi jest czymś odurzona. Technicznie nie był to deepfake, ale nagranie rodziło pytania o to, jak łatwo można spreparować i rozpowszechniać wideo. Pod koniec czerwca 2019 roku kontrowersyjna aplikacja internetowa DeepNude pozwalała użytkownikom na tworzenie realistycznych obrazów nagich kobiet za pomocą przesłanych do aplikacji zdjęć prawdziwych osób. Pokazuje to, że algorytmy mogą być wykorzystywane do nikczemnych czynów. Od tego czasu aplikacja została usunięta.

Manipulacja cyfrowymi filmami i obrazami nie jest niczym nowym, ale nowe są już postępy w dziedzinie sztucznej inteligencji, łatwiejszy dostęp do narzędzi oraz skala, w jakiej można rozpowszechniać spreparowane materiały wideo. John Villasenor z Instytutu Brookingsa i Uniwersytetu Kalifornijskiego w Los Angeles twierdzi, że ostatnie dwa punkty są w dużej mierze powodem, dla którego deepfake'i mogą budzić większe obawy niż pojawienie się w przeszłości innych narzędzi do edycji zdjęć i filmów.

– Każdy jest teraz globalnym nadawcą – mówi Villasenor – Myślę, że te dwie rzeczy tworzą fundamentalnie inne środowisko niż wtedy, gdy pojawił się Photoshop – zaznacza.

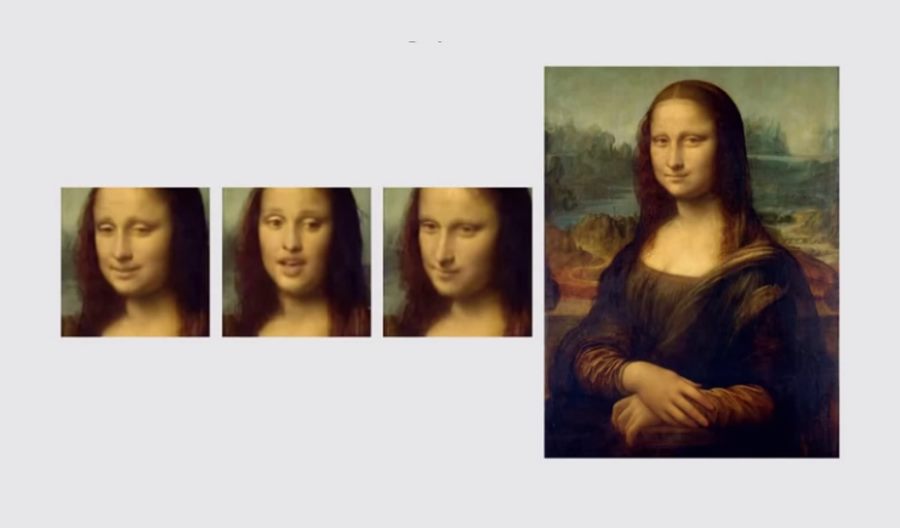

Villasenor tłumaczy, że deepfake’i tworzy się przy użyciu danych treningowych – tj. obrazów lub filmów wideo podmiotu – które służą do powstania trójwymiarowego modelu osoby. Ilość wymaganych danych może się różnić w zależności od używanego systemu i jakości podróbki, którą próbujesz stworzyć. Zdaniem Farhadiego opracowanie przekonywującego deepfake'a może wymagać tysięcy zdjęć i nagrań. Samsung opracował jednak system AI, który był w stanie wygenerować sfabrykowany klip wideo z użyciem zaledwie jednego zdjęcia.

Nawet jeśli technologia jest łatwiej dostępna i bardziej wyrafinowana niż kiedyś, to – zdaniem Farhadiego – nadal wymaga pewnego poziomu wiedzy. Trzeba rozumieć algorytmy deep learning.

– To nie jest tak, że kliknięciem przycisku zaczynasz generować deepfake’i – mówi Farhadi. – Wymaga to wiele pracy – dodaje.

Deepfake - problem całego świata

Prawdopodobnie nie da się zapobiec tworzeniu deepfake'ów lub zakazać ich rozpowszechniania w mediach społecznościowych i innych miejscach. Ale nawet gdyby było to możliwe, całkowite zakazanie deepfake’ów prawdopodobnie nie jest rozwiązaniem. Maneesh Agrawala, profesor informatyki z Forest Baskett i dyrektor Brown Institute for Media Innovation na Uniwersytecie Stanforda, zaznacza, że to nie sama technologia, ale sposób jej wykorzystania może być problematyczny. Wyeliminowanie deepfake’ów może nie usunąć źródła problemu.

– Błędne informacje mogą być prezentowane, nawet jeśli film jest w stu procentach prawdziwy – mówi Agrawala – Obawy dotyczą samych dezinformacji, a nie technologii, które służą do tworzenia tych filmów – dodaje.

Wyścig zbrojeń

Nasuwa się pytanie, co można zrobić, aby zapobiec wykorzystywaniu deepfake’ów w niebezpieczny i szkodliwy sposób. Eksperci zdają się zgadzać co do tego, że istnieją dwa potencjalne podejścia: rozwiązania technologiczne, które mogą wykryć, kiedy film został sfałszowany oraz ramy prawne, które penalizują tych, którzy używają tej technologii, aby oczerniać innych. Żadna z tych ścieżek nie będzie niezawodna i nadal nie jest jasne, w jaki sposób takie poprawki mogłyby działać.

Mimo że nie istnieje jeszcze jasne rozwiązanie, pytanie o to, jak zająć się deepfake’ami, było tematem dyskusji w Kongresie USA w ostatnich miesiącach. W grudniu 2018 roku republikański senator Ben Sasse z Nebraski zaproponował ustawę znaną jako "Malicious Deep Fake Prohibition Act of 2018", która ma na celu zakazanie "preparowania nagrań audiowizualnych". Ustawa "DEEP FAKES Accountability Act" zaproponowana w czerwcu przez reprezentantkę Demokratów z Nowego Jorku Yvette Clarke wymaga, aby fałszowane nagrania były wyraźnie oznaczone znakiem wodnym. Proponowany projekt ustawy nakładałby również kary za naruszenia zasad.

Wprowadzenie przepisów, które miałyby na celu rozwiązanie problemu deepfake’ów w sposób, który nie naruszałby wolności słowa lub nie miałby wpływu na dyskurs publiczny, mogłoby stanowić wyzwanie – nawet jeśli takie przepisy przewidują wyjątki dla treści rozrywkowych, jak zauważa Electronic Frontier Foundation.

Deepfake przedstawiający Marka Zuckerberga został na przykład stworzony jako część wystawy na festiwalu filmów dokumentalnych. – Myślę, że to ważne, aby zachować ostrożność, gdy mówimy o potencjalnych szkodach – mówi Agrawala. Wraz z innymi badaczami z Uniwersytetu Stanforda, Max Planck Institute for Informatics, Universytetu w Princeton i Adobe Research stworzyła algorytm, który pozwala edytować filmy z "gadającymi głowami" poprzez wprowadzanie tekstu. – Myślę, że istnieje wiele naprawdę ważnych przypadków zastosowania tego rodzaju technologii – tłumaczy.

Podejmowanie działań prawnych jest często czasochłonne, co może utrudnić stosowanie środków mających łagodzić potencjalne szkody wynikające z oszustw.

– Wpłynięcie na cykl wyborczy dzięki mediom społecznościowym to czasami kwestia dni lub nawet godzin. Działania prawne mogą trwać tygodniami lub miesiącami – mówi Villasenor – W wielu przypadkach szkody byłyby już wyrządzone – dodaje.

Według Farhadiego jednym z najskuteczniejszych sposobów rozwiązania tego problemu jest budowanie systemów, które potrafią odróżnić deepfake’i od prawdziwych nagrań. Można to osiągnąć, stosując algorytmy podobne do tych, które zostały opracowane w celu tworzenia deepfake’ów, ponieważ dane te mogą być wykorzystywane do szkolenia detektorów.

Sean Gourley, założyciel i dyrektor generalny Primer AI, firmy zajmującej się inteligencją maszynową, która tworzy produkty do analizy dużych zbiorów danych, uważa, że może to jednak nie wystarczyć w wykrywaniu bardziej wyrafinowanych deepfake’ów w miarę ich dalszego rozwoju.

– Można myśleć o tym jak o atakach typu zero-day w sektorze cyberbezpieczeństwa – mówi Gourley – Atak zero-day jest atakiem, którego nikt wcześniej nie widział, a zatem nie ma przed nim obrony –tłumaczy.

Jak to często bywa w przypadku cyberbezpieczeństwa, osobom próbującym rozwiązać problemy i naprawić błędy trudno jest wyprzedzić tych, którzy starają się wyrządzić szkody. To samo, zdaniem Villasenora, dotyczy deepfake’ów.

– To rodzaj wyścigu zbrojeń – mówi – Wykrywanie zagrożeń zawsze będzie o kilka kroków wstecz – dodaje.

Użytkownik Nick edytował ten post 14.07.2019 - 21:22